Künstliche Intellligenz (KI) hat in atamberaubenden Tempo unser Leben durchdrungen und formt zunehmend unsere Zukunft. Mit der Bereitstellung eines Zugangs zu Künstlicher Intelligenz in Form von ChatGPT ist es kaum mehr möglich, diesen Trend zu ignorieren. Um zu verstehen, wo wir mit dieser Schlüsseltechnologie im 21. Jahrhundert hinsteuern, ist es hilfreich, einen Blick in die Vergangenheit zu werfen und den Verlauf der Entwicklung nachzuvollziehen.

In mehreren Abschnitten durchqueren wir verschiedene Etappen in der Entwicklung der Künstlichen Intelligenz – von den Vorläufern über die ersten Schritten in den 1950er Jahren, den sogenannten „KI-Winter“ bis hin zum Aufstieg des maschinellen Lernens und dem heutigen Stand von KI. Schließlich richten wir unseren Blick auf die Chancen und Risiken sowie die kommenden Jahre, in denen KI bedeutende soziale und ethische Herausforderungen mit sich bringen könnte.

Inhalt:

- Was ist Künstliche Intelligenz?

- Die Vorläufer der Künstlichen Intelligenz (1930er- bis 1940er-Jahre)

- Die Frühzeit der Künstlichen Intelligenz (1950er- bis 1960er-Jahre)

- Künstliche Intelligenz im „KI-Winter“ (1970er- bis 1980er-Jahre)

- Der Aufstieg des Maschinellen Lernens (1990er bis frühe 2000er-Jahre)

- Durchbruch der Künstlichen Intelligenz im 21. Jahrhundert

- Bedeutende KI-Entwicklungen seit 2020

- Die KI-Strategie der Bundesregierung Deutschlands

- Die Zukunft der Künstlichen Intelligenz bis 2030

1. Was ist Künstliche Intelligenz

Künstliche Intelligenz (KI) ist die Nachahmung menschlicher Fähigkeiten durch Maschinen, insbesondere Kompetenzen wie logisches Denken, Lernen und Planen. Sie ermöglicht es Maschinen, Robotern und Fahrzeugen, ihre Umgebung wahrzunehmen, auf wahrgenommene Daten zu reagieren und selbstständig zu handeln. Künstliche Intelligenz (KI) ist heute allgegenwärtig, insbesondere in Bereichen wie Online-Shopping, Suchmaschinen, digitalen Assistenten, Robotik, Übersetzungstools und autonomes Fahren. Auch in spezielleren Gebieten wie Medizin und Cybersicherheit spielt KI eine wichtige Rolle.

Zukünftige KI-Anwendungen könnten erhebliche Veränderungen in unserem Alltag bewirken, wobei die Gesetzgeber momentan dabei sind, die Chancen und Risiken abzuwägen und mit einem legalen Rahmen zu koordinieren. Die globalen Umsätze mit KI-Anwendungen werden für 2025 auf etwa 31 Milliarden US-Dollar geschätzt. In der Industrie ist die Robotertechnik auf dem Vormarsch. Digitale Sprachassistenten wie Amazons Alexa, Google Assistant und Apples Siri sind tägliche Begleiter vieler Menschen, insbesondere im Haushalt. Autonomes Fahren rückt trotz anhaltender Sicherheitsbedenken zunehmend in den Fokus. Prognosen zufolge wird die Zahl der voll- und teilautomatisierten Pkw in Europa von 2018 bis 2030 auf rund 33 Millionen ansteigen.

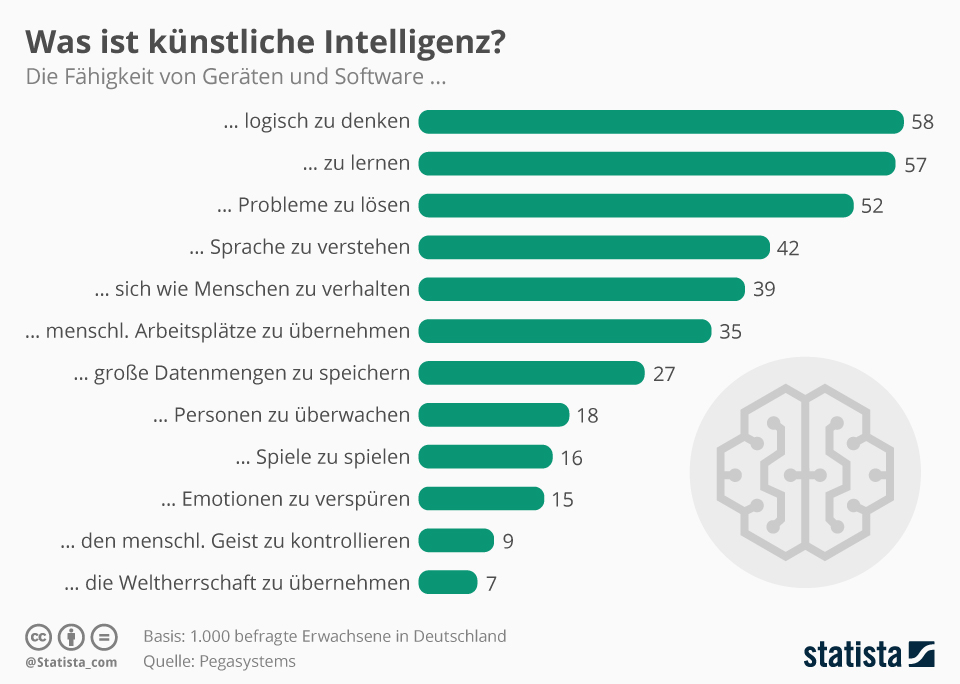

Im Jahr 2017 führte Pegasystems eine Umfrage unter Deutschen durch, was es mit Künstlicher Intelligenz (KI) auf sich hat. Eine Mehrheit verstand darunter die Fähigkeit von Geräten und Software logisch zu denken (58 %), zu lernen (57 %) und Probleme zu lösen (52 %). Emotionen nannten dagegen nur 15 % als KI-Merkmal. Allerdings gab es auch Antworten wie „den menschlichen Geist kontrollieren“ oder „die Weltherrschaft übernehmen“.

2. Die Vorläufer der Künstlichen Intelligenz (1930er)

Die Geschichte der Künstlichen Intelligenz beginnt viel früher, als wir uns bildlich vorstellen können. Obwohl er oft übersehen wird, könnte man den armenisch-französischen Erfinder Georges Artsrouni und seine „elektrische Gehirnmaschine“ als Vorläufer der Künstlichen Intelligenz bezeichnen. Schon in den 1930er Jahren verfolgte Artsrouni das Ziel, eine Maschine zu entwickeln, um Informationen zu speichern und abzurufen, was wir heute als Datenbanken kennen. Obwohl seine Arbeit nicht direkt mit dem heutigen Begriff „Künstliche Intelligenz“ assoziiert wird, hat Artsrouni einen wichtigen Beitrag zur Informationsverarbeitung und Datenanalyse geleistet, die wesentliche Komponenten der modernen KI sind.

3. Frühzeit der Künstlichen Intelligenz (1950er bis 1960er)

Die 1950er-Jahre markieren die formelle Geburt der Künstlichen Intelligenz als wissenschaftliches Feld. Der Begriff „Künstliche Intelligenz“ wurde erstmals 1956 bei der berühmten Dartmouth-Konferenz geprägt, bei der die damaligen KI-Architekten zusammenkamen, um die Grundlagen und das Potenzial dieser aufstrebenden Forschung zu diskutieren. Mit dabei waren unter anderem John McCarthy und Marvin Minsky, zwei wichtige Pioniere auf diesem Gebiet. John McCarthy, der Organisator der Konferenz, gilt heute bei vielen als wahrer Schöpfer der neuen Disziplin. McCarthy selbst fühlte sich geehrt, aber in seinen Augen dürfe man Alan Turing nicht vergessen, der schon 1947 auf einem Symposium in Manchester die zentrale Frage der Künstlichen Intelligenz formulierte: „Können Maschinen denken?

In dieser Phase der frühen Entwicklung wurden überwiegend sogenannte Expertensysteme entwickelt, die spezielles Wissen in bestimmten Bereichen sammeln und anwenden konnten. Sie basierten auf Regeln und Algorithmen, die von Experten auf einem bestimmten Gebiet festgelegt und im System gespeichert wurden. Der Ansatz war vom symbolischen Denken geprägt, bei dem Maschinen mit symbolischen Darstellungen von Problemen programmiert wurden, um menschenähnliche Fähigkeiten zur Problemlösung zu demonstrieren. Das System entscheidet auf Basis des vorhandenen Wissens und der Erfahrung von Experten, was allerdings auch die Grenzen festlegte. Erscheint ein neues Problem, für das keine Regeln existieren, kann das Expertensystem keine Ergebnisse liefern.

Ein bekanntes Beispiel für ein solches Expertensystem ist das Schachprogramm von Allen Newell und Herbert A. Simon, das einen menschlichen Spieler simulieren konnte, indem es die besten Züge auf der Grundlage einer Baumstruktur von möglichen Spielzuständen auswählte.

3.1. Das Perzeptron von Frank Rosenblatt und NLP-Grundlagen

1958 präsentierte Frank Rosenblatt das Perzeptron, das als frühes Modell für künstliche neuronale Netze angesehen werden kann und eine wichtige Grundlage für die spätere Entwicklung des maschinellen Lernens und Deep Learning legte. Trotz seiner Begrenzungen ist das Perzeptron ein wichtiger Meilenstein in der Geschichte der KI und hat die Forschung maßgeblich vorangetrieben.

Einen wichtigen wissenschaftlichen Beitrag zur Entwicklung der sprachlichen Fähigkeiten der Maschinen lieferte auch der Linguist und Philosoph Noam Chomsky, insbesondere im Bereich des Natural Language Processing (NLP). Eine seiner wichtigsten Arbeiten war die Theorie der „Generativen Grammatik“, die auf der Idee basierte, dass alle menschlichen Sprachen eine zugrundeliegende, universelle Grammatik teilen, womit er das Konzept des Natural Language Processing (NLP) einführte.

Ein konsequenter Meilenstein dieser Ära war ELIZA (1966), ein frühes Natural Language Processing (NLP) Programm, das Joseph Weizenbaum am MIT entwickelt hatte. ELIZA war in der Lage, einfache Gespräche mit Benutzern zu führen, indem es vordefinierte Skripte verwendete, was einen bedeutenden Fortschritt in der Interaktion zwischen Mensch und Maschine darstellte.

Die KI-Architekten in dieser Phase haben damals den Grundstein für viele der modernen Konzepte und Technologien gelegt, die ihre Nachfolger in den folgenden Jahrzehnten weiterentwickelten. Es entwickelte sich ein Verständnis, wie maschinelles Denken funktionieren könnte.

4. Künstliche Intelligenz im KI-Winter (1970er bis 1980er)

Trotz der frühen Erfolge erfüllten viele Versprechen der künstlichen Intelligenz nicht die Erwartungen. Maschinen vermochten es nicht, die Komplexität menschlicher Intelligenz zu erreichen – es mangelte an ausreichenden Hard- und Software-Ressourcen. In dieser Phase, bekannt als der erste KI-Winter, erlebten die Wissenschaftler Rückschläge, Skepsis und eine spürbare Verlangsamung des Fortschritts. Es war eine Phase der Ernüchterung und Konsolidierung, in der die führenden KI-Architekten gezwungen waren, ihre Ziele und Methoden zu überdenken.

4.1. Der Lighthill-Report 1973

Die technischen und theoretischen Grenzen schienen überwältigend, und der Traum von menschenähnlichen Robotern blieb unerfüllt. Interesse und Finanzierung ließen nach, wie der britische Lighthill-Report von 1973 verdeutlichte, ein Phänomen, das auch in den USA spürbar war. Der Lighthill-Report im Auftrag der britischen Regierung, erstellt von dem angesehenen Professor Sir James Lighthill, kritisierte den damaligen Fortschritt in der KI-Forschung als unzureichend und überbewertet. Er führte zu einer erheblichen Kürzung der staatlichen Fördermittel für KI-Projekte in Großbritannien und markierte den Beginn eines Jahrzehnts der Stagnation.

4.2. Entwicklung von Expertensystemen

Trotz dieser Herausforderungen gab es signifikante Fortschritte in Teilbereichen der KI, wie beispielsweise bei den ersten Expertensystemen MYCIN in der medizinischen Diagnostik und DENDRAL in der organischen Chemie. Im Bereich der Computerspiele prägten Michael Toy, Glenn Wichman und Ken Arnold mit ihrem komplexen UNIX-basierten Spiel „Rogue“ die prozedurale Erzeugung des Spiels. Der Reiz des extrem simpel aufgebauten Spiels bestand darin, dass man es ohne langwieriges Studium einer Anleitung spielen konnte und jede Partie ein vollkommen neues Erlebnis generierte. Wiederholungen waren ausgeschlossen und der Spieler wusste nie, was ihn genau erwartet.

4.3. Judea Pearl und Bayes’sche Netze

Judea Pearl legte in den 1980er-Jahren mit seinen Bayes’schen Netzen den Grundstein für den Umgang mit Unsicherheit in KI-Systemen. Seine Ergebnisse ermöglichten es, probabilistische Modelle zu erstellen, die komplexe Abhängigkeiten und Unsicherheiten in Daten darstellen können. Pearl’s Arbeit revolutionierte die Art und Weise, wie KI-Systeme inferenzielle Prozesse durchführen und Entscheidungen treffen. Seine Forschung hat weitreichende Anwendungen gefunden, von maschinellem Lernen über Diagnose-Systeme bis hin zur Spracherkennung. Für seine bahnbrechenden Beiträge zur KI und Statistik erhielt er zahlreiche Auszeichnungen, darunter den Turing Award im Jahr 2011.

4.4. Back-Propagation-Algorithmus und Convolutional Neural Networks (CNNs)

Ein weiterer wichtiger Schritt war die Entwicklung des Back-Propagation-Algorithmus. David Rumelhart, Geoffrey Hinton und Ronald Williams hatten diesen in den 1980er-Jahren populär gemacht. Er revolutionierte die Art und Weise, wie neuronale Netze trainiert wurden. Durch ihre Forschung konnten sie zeigen, wie Back-Propagation zur Lösung komplexer Probleme eingesetzt werden kann. Damit legten sie den Grundstein für den Erfolg von tiefen neuronalen Netzen in den folgenden Jahrzehnten.

Parallel dazu entwickelten Yann LeCun, Yoshua Bengio und Patrick Haffner sogenannte Convolutional Neural Networks (CNNs), die insbesondere die Bilderkennung revolutionierten. Michael Jordan verbesserte mit seiner Arbeit an rekurrenten neuronalen Netzwerken (RNNs) die Verarbeitung von Sequenzdaten wie Text oder Sprache.

5. Aufstieg des Maschinellen Lernens (1990er bis frühe 2000er)

Die 1990er-Jahre kennzeichneten den Beginn einer neuen Ära der Künstlichen Intelligenz. Sie war geprägt vom Aufstieg des Maschinellen Lernens (ML), ein Teilbereich der Künstlichen Intelligenz. Es geht darum, Algorithmen zu entwickeln, die es Computern ermöglichen, aus Daten zu lernen und auf dieser Basis Vorhersagen oder Entscheidungen zu treffen, ohne explizit dafür programmiert zu sein.

Diese Entwicklung führte uns zu Anwendungen wie in der Suchmaschine von Google und Empfehlungssystemen wie bei Amazon. Zudem konnten bedeutende Fortschritte in der Sprach- und Bilderkennung erzielt, die den Weg für Technologien wie virtuelle Assistenten und fortschrittliche Bildverarbeitung ebneten.

In dieser Phase profitierte die KI-Forschung von einer Kombination begünstigender Faktoren, darunter die zunehmende Verfügbarkeit von Daten und die Fortschritte in der Rechenleistung der Computer. Maschinelles Lernen ermöglichte den Fortschritt bis hin zur Bewältigung komplexer und nuancierter Aufgaben durch Maschinen. Ein wichtiger Meilenstein war der Sieg des Schach-Computers Deep Blue im Jahr 1997 gegen den damaligen Weltmeister Garry Kasparov. Dieser Moment erbrachte den lang ersehnten Beweis, dass KI-Systeme in der Lage sein könnten, das menschliche Gehirn in komplexen Spielen zu übertreffen.

Zudem waren die 1990er-Jahre geprägt von der Entwicklung von Support Vector Machines (SVMs) und Random Forests. Diese Techniken erweiterten das Arsenal der ML-Methoden und trugen zu seiner breiten Anwendung in einer Vielzahl von Bereichen bei. In den frühen 2000er-Jahren trug die KI-Forscherin Fei-Fei Li maßgeblich zur Fortentwicklung der KI bei. Sie leitete das Projekt ImageNet, eine Datenbank mit Millionen von annotierten Bildern, die die Forschung im Bereich des maschinellen Sehens revolutionierte.

KI-Forscher wie Geoffrey Hinton, Yann LeCun und Yoshua Bengio trieben gleichzeitig die Entwicklung von Deep Learning voran. Dabei handelt es sich um eine spezielle Form des ML, das auf künstlichen neuronalen Netzen basiert. Dies war die Basis für bedeutende Fortschritte in der Spracherkennung und maschineller Übersetzung.

6. Durchbruch der künstlichen Intelligenz im 21. Jahrhundert

Das 21. Jahrhundert markiert eine Ära wichtiger Durchbrüche und signifikanter Fortschritte in der Entwicklung der Künstlichen Intelligenz (KI), die nun exponentielles Wachstum verzeichnet. Solche Fortschritte wurden maßgeblich durch bahnbrechende Verbesserungen in der Hardware mit immenser Zunahme der Rechenleistung (GPUs/TPUs), der Verfügbarkeit riesiger Datenmengen (Big Data) und Fortschritten in Algorithmen und Modellen (wie CNNs, RNNs, neuronale Netze, Transformer-Modelle) ermöglicht.

6.1. Neuronale Netze und Deep Learning

Neuronale Netze sind KI-Modelle, die von der Funktionsweise des menschlichen Gehirns inspiriert sind. Sie sind ein zentrales Element des maschinellen Lernens und der künstlichen Intelligenz. Sie bestehen aus miteinander verbundenen Knoten (Neuronen), die in drei Schichten organisiert sind: Die Eingabeschicht nimmt Daten auf, die verborgenen Schichten verarbeiten ihre Merkmale, und die Ausgabeschicht liefert das Ergebnis oder die Vorhersage. Neuronale Netze imitieren das menschliche Gehirn, das aus Milliarden von Neuronen besteht, die über Synapsen Signale austauschen und alle kognitiven und körperlichen Funktionen durch komplexe, dynamische Interaktionen steuern.

Ein bedeutender Durchbruch in der Entwicklung neuronaler Netze war die Einführung von AlexNet (2012), das der kanadische Informatiker Alex Krizhevsky zusammen mit Ilya Sutskever und Geoffrey Hinton entwickelt hatte. AlexNet dominierte den damaligen ImageNet-Wettbewerb, einen jährlichen KI-Wettbewerb, bei dem es um den Test von Algorithmen zur Objekterkennung und Bildklassifizierung auf einem großen Datensatz von Bildern geht.

In den Jahren 2009 bis 2012 erlangte das Schweizer KI-Labor IDSIA weltweite Anerkennung für ihre bahnbrechenden Forschungen im Bereich des Deep Learning. Unter der Leitung von Jürgen Schmidhuber entwickelte IDSIA fortschrittliche Algorithmen wie rekurrente neuronale Netze (RNNs) und Long Short-Term Memory (LSTM) Netzwerke.

Es folgte word2vec von Thomas Mikolov (2013), ein Tool, das bedeutende Fortschritte in der natürlichen Sprachverarbeitung ermöglichte. Ian Goodfellow faszinierte im folgenden Jahr die KI-Forscher (2014) mit der Einführung der Generative Adversarial Networks (GANs), womit sich realistische Bilder generieren lassen.

Ab 2015 beschleunigte sich die Bedeutung und der Aufstieg des maschinellen Lernens, insbesondere des Deep Learning. Diederik Kingma und Max Welling entwickelten die Diffusion Models (2015), eine neue Modellklasse im maschinellen Lernen, die bedeutenden Fortschritte in der Generierung und Modellierung komplexer Daten ermöglichten. Diese Entwicklungen trugen wesentlich dazu bei, die Leistungsfähigkeit von KI-Systemen in Bereichen wie Bild- und Sprachverarbeitung, generativer Modellierung und vielen anderen Anwendungen zu verbessern.

6.2. Google: Einführung der Transformer-Modelle

Die Einführung von Transformer-Modellen im Jahr 2017 markierte einen bedeutenden Durchbruch in der Entwicklung künstlicher Intelligenz und leitete einen Paradigmenwechsel in der natürlichen Sprachverarbeitung (NLP) ein. Google präsentierte in diesem Jahr die ersten Large Language Models (LLMs), die auf riesigen Textmengen trainiert wurden, um im Ergebnis menschenähnliche Texte zu erzeugen und komplexe NLP-Aufgaben zu bewältigen. Diese Entwicklung stellte einen Paradigmenwechsel dar und legte das Fundament für viele moderne Sprachmodelle.

Der Schlüssel zum Erfolg der Transformer-Modelle ist ein besonderer Mechanismus, der es dem Modell ermöglicht, sich auf verschiedene Teile einer Eingabesequenz gleichzeitig zu fokussieren und Abhängigkeiten zwischen Wörtern unabhängig von ihrer Position zu erkennen. Dadurch ist das Modell in der Lage, den Kontext und die Genauigkeit bei der Verarbeitung von Texten erheblich zu verbessern. Ein weiterer entscheidender Vorteil der Transformer-Modelle ergibt sich aus ihrer Fähigkeit zur parallelen Datenverarbeitung. Im Vergleich zur sequenziellen Datenverarbeitung bei rekurrenten neuronalen Netzen (RNNs) und Long Short-Term Memory (LSTM) Netzwerken ermöglicht die parallele Datenverarbeiten höhere Geschwindigkeiten beim Training und bei der Inferenz, was die Handhabung riesiger Datenmengen erheblich erleichtert.

Im Jahr 2018 präsentierte Google BERT (Bidirectional Encoder Representations from Transformers), ein Transformer-basiertes Modell, das die Bedeutung von „Large Language Modellen“ in der KI-Entwicklung weiter verstärkte. BERT setzte neue Maßstäbe in vielen NLP-Aufgaben, darunter Textklassifikation, maschinelle Übersetzung und Fragebeantwortung.

6.3. OpenAI: ChatGPT und Dall-E

OpenAI betrat 2018 die KI-Bühne mit seinem Sprachmodell ChatGPT, das eine Chatbot-Anwendung von GPT ist, die speziell für die Interaktion in natürlichen Gesprächen optimiert wurde. GPT steht für „Generative Pre-trained Transformer“.

Es ist ein KI-Modell, das darauf spezialisiert ist, menschenähnliche Texte zu generieren. Es versteht und antwortet auf natürliche Spracheingaben und kann sogar den Kontext erfassen, um eine passende und relevante Antwort zu geben. Das Modell wird durch ein zweistufiges Verfahren trainiert: zuerst wird es auf einer großen Menge Textdaten vortrainiert (Pre-training), um ein allgemeines Verständnis der Sprache zu entwickeln. Anschließend erfolgt ein Feintuning mit einer Abstimmung auf spezifische Aufgaben.

GPT ist ein Sprachmodell, das Texte basierend auf Mustern und Zusammenhängen generiert, die es während des Trainings gelernt hat. Es speichert keine spezifischen Fakten oder Daten wie eine Datenbank, sondern erzeugt die Antworten auf eine Frage dynamisch und auf Basis von Wahrscheinlichkeiten. GPT hat kein explizites Wissen oder ein echtes Verständnis von Fakten, sondern verwendet Wahrscheinlichkeiten, um plausible Texte zu erzeugen. GPT weiß also nicht, dass Albert Einstein ein berühmter Physiker war. Dennoch kann es auf die Frage „Wer ist Albert Einstein?“ eine präzise Antwort liefern:

Albert Einstein (1879–1955) war ein deutscher theoretischer Physiker, der als einer der bedeutendsten Wissenschaftler des 20. Jahrhunderts gilt. Er ist vor allem für seine Entwicklung der Relativitätstheorie bekannt, insbesondere für die spezielle Relativitätstheorie und die Allgemeine Relativitätstheorie. Einsteins berühmteste Gleichung, E = mc², beschreibt die Beziehung zwischen Masse und Energie.

Einstein erhielt 1921 den Nobelpreis für Physik, jedoch nicht für die Relativitätstheorie, sondern für seine Erklärung des photoelektrischen Effekts, die wesentlich zur Entwicklung der Quantenmechanik beitrug. Seine Arbeiten revolutionierten das Verständnis von Raum, Zeit, Gravitation und Energie.

Einstein war auch für sein Engagement in sozialen und politischen Fragen bekannt. Er setzte sich für Pazifismus, Zionismus und Bürgerrechte ein und warnte vor den Gefahren von Atomwaffen. Nach seiner Emigration aus Deutschland aufgrund der Machtergreifung der Nationalsozialisten lebte er in den USA und arbeitete am Institute for Advanced Study in Princeton, New Jersey, bis zu seinem Tod.

Diese Antwort auf die Frage „Wer ist Albert Einstein?“ sieht den Texten aus den Datensätzen, mit denen GPT trainiert wurde, am ähnlichsten und erscheint für den Menschen sinnvoll. GPT kann jedoch nicht beurteilen, ob diese Information tatsächlich richtig ist oder nicht.

GPT-2, GPT-3

Die Zahlen hinter „GPT“ beziehen sich auf die Version des Modells:

- GPT-1: Die erste Version des Generative Pre-trained Transformer Modells, das grundlegende Fähigkeiten zur Textgenerierung demonstrierte.

- GPT-2: Eine weiterentwickelte Version mit 1,5 Milliarden Parametern, die deutlich bessere Ergebnisse bei der Textgenerierung und -verständnis zeigte.

- GPT-3: Die dritte Version, die 2020 veröffentlicht wurde. Sie hat 175 Milliarden Parameter und repräsentiert einen erheblichen Fortschritt in der Fähigkeit, menschenähnliche Texte zu erzeugen und komplexe Aufgaben im Bereich der natürlichen Sprachverarbeitung zu bewältigen.

GPT-4

Seit März 2023 haben wir die Möglichkeit, mit GPT-4 zu arbeiten, das auf Basis der vorherigen Modelle weiterhin verbessert wurde und nun noch größere, komplexere Aufgaben bewältigen kann. Bis auf Weiteres werden die Large-Language-Modells (LLMs) wohl eine zentrale Rolle bei der Weiterentwicklung der KI spielen.

Dall-E

2021 führte OpenAI Dall-E ein, das Bilder auf Basis von Textbeschreibungen erzeugen kann. Schon 2020 folgte das GPT-3 Modell, eine deutliche Verbesserung gegenüber GPT-2. GPT-3 hat in vielerlei Hinsicht Maßstäbe gesetzt, insbesondere im Hinblick auf die Fähigkeit, menschenähnliche Texte zu generieren. Mit GPT-3 hat OpenAI gezeigt, wie Large Language Models komplexe Aufgaben wie das Verfassen von Essays, Übersetzungen und sogar einfache Programmieraufgaben durchführen können.

7. Weitere bedeutende KI-Entwicklungen seit 2020

Die weiteren bemerkenswerten Fortschritte in der Künstlichen Intelligenz seit 2020 lassen sich auf eine Kombination aus technologischen Innovationen und verbesserten Lernmethoden zurückführen. Ein zentraler übergeordneter Nenner ist der exponentielle Anstieg der Rechenleistung, ermöglicht durch spezialisierte Hardware wie GPUs und TPUs, die komplexe Modelle effizienter trainieren können.

Gleichzeitig hat die digitale Transformation in vielen Lebensbereichen riesige Datenmengen verfügbar gemacht, die für das Training hochentwickelter KI-Modelle eingesetzt werden können. Fortschritte beim maschinellen Lernen und verbesserte Algorithmen haben es zudem ermöglicht, aus weniger Daten mehr Erkenntnisse zu gewinnen.

All diese Entwicklungen haben dazu geführt, dass nicht nur erhebliche Investitionen in die Entwicklung künstlicher Intelligenz geflossen sind, sondern auch die Zusammenarbeit von Forschungsinstituten und Unternehmen intensiviert hat. Insgesamt stehen wir vor einer sehr dynamischen Innovationslandschaft.

7.1. DeepMind AlphaFold 2 (2020)

2020 stellte DeepMind AlphaFold vor, ein KI-System, das das Problem der Protein-Faltung löste. Diese Entwicklung hatte erhebliche Auswirkungen auf die biomedizinische Forschung, da sie die Vorhersage der 3D-Struktur von Proteinen aus ihrer Aminosäuresequenz ermöglichte und somit neue Wege für die Medikamentenentwicklung und die Erforschung biologischer Prozesse eröffnete.

7.2. Autonomes Fahren – Full Self-Driving (FSD)

Eine lang erwartete Anwendung künstlicher Intelligenz ist der Bereich des autonomen Fahrens (Full Self-Driving), der

Das Autopilot-System von Tesla verwendet eine Vielzahl von Sensoren und ein neuronales Netz, die in der Lage sind, komplexe Szenarien zu erkennen und zu interpretieren, wie z.B. andere Fahrzeuge, Fußgänger, Verkehrszeichen und Straßenmarkierungen. Durch kontinuierliches Lernen aus riesigen Datenmengen, die von der gesamten Tesla-Flotte erzeugt und gesammelt werden, verbessern sich die Modelle ständig weiter. Die bislang verfügbaren Funktionen umfassen das autonome Navigieren auf Autobahnen und Stadtstraßen, automatisches Einparken, Summon (Herbeirufen des Fahrzeugs aus der Ferne) und Reaktionen auf Ampeln und Stoppschilder.

7.3. Second-Order-Optimierung

Die Second-Order-Optimierung trägt dazu bei, KI-Modelle schneller und genauer zu trainieren. Obwohl diese Methoden sehr effektiv sind, waren sie bisher oft zu kompliziert und rechenintensiv.

2024 hat das Team der Stanford University Sophia entwickelt, einen neuen Ansatz zur Beschleunigung des Vortrainings großer Sprachmodelle (LLMs), der doppelt so schnell sein soll wie bisherigen Methoden. Large Language Models (LLMs) sind kostenintensiv im Vortraining und daher oft nur für große, gut finanzierte Technologieunternehmen zugänglich. Sophia soll das auf Basis der Second-Order-Optimierung ändern, indem die Zeit des Vortrainings halbiert wird.

8. Chancen und Risiken der Künstlichen Intelligenz

Künstliche Intelligenz (KI) hat sich zu einem bedeutenden Motor für Innovationen und Wachstum entwickelt, der in einer Vielzahl von Bereichen immense Chancen für Wirtschaft, Gesellschaft und Sicherheit bietet, aber in anderen auch erhebliche Risiken birgt.

8.1. Chancen der Künstlichen Intelligenz

Die Chancen der künstlichen Intelligenz (KI) sind vielfältig. Besonders hervorzuheben ist das Potenzial für Wirtschaftswachstum und Produktivitätssteigerungen. Ein wesentlicher Vorteil liegt in den Fortschritten, die KI in der Datenverarbeitung gemacht hat. Sie ermöglicht effiziente Analysen großer Datenmengen und die Ableitung nützlicher Informationen und Vorhersagen. Dies erleichtert Unternehmen und Organisationen fundierte Entscheidungen und die Optimierung von Prozessen. Des Weiteren bietet KI signifikante Verbesserungen im Gesundheitswesen, etwa durch präzisere Diagnoseverfahren oder individualisierte Therapien. Außerdem kann KI den Zugang zu Bildung und Informationen erleichtern, beispielsweise durch personalisierte Lernprogramme oder intelligente Suchmaschinen. Eine kontroverse Debatte gibt es noch zur Rolle der KI in Bezug auf die Verkehrssicherheit, insbesondere in der Anwendung bei selbstfahrenden Fahrzeugen.

Durch die Automatisierung von gefährlichen Arbeitsschritten kann KI zur Erhöhung der Arbeitsplatzsicherheit beitragen. Unternehmen können durch die Entwicklung innovativer Produkte und Dienstleistungen profitieren, den Kundenservice optimieren und die betriebliche Produktivität steigern. KI findet auch in der öffentlichen Verwaltung Anwendung, wo vor allem die Kostensenkung und die Nachhaltigkeit von Prozessen im Vordergrund stehen. Ein prominentes Beispiel ist der Einsatz von KI zur Umsetzung der Ziele des Grünen Deals, etwa durch effizientere Energieverwaltung oder Optimierung von Abfallwirtschaftsprozessen.

8.2. Risiken der Künstlichen Intelligenz

Ungeachtet der Chancen birgt die zunehmende Abhängigkeit von KI-Systemen auch erhebliche Risiken. Eine große Sorge betrifft die Frage der Haftung bei Schäden, die durch Künstliche Intelligenz verursacht werden. Gesetzgeber müssen klären, wer im Falle eines Unfalls mit einem autonomen Fahrzeug oder Roboter die Verantwortung trägt – der Eigentümer, der Hersteller oder der Programmierer.

KI-Systeme bergen auch Risiken für demokratische Grundprinzipien und Grundrechte im Besonderen, da sowohl Algorithmen als auch die zugrundeliegenden Daten verzerrt oder manipuliert sein können, was zu diskriminierenden oder falschen Entscheidungen führen könnte. Deepfakes könnten dazu genutzt werden, einzelne oder mehrere Menschen mit künstlich erstellten Videos oder Audiodateien zu ungewollten Handlungen oder negativen Entscheidungen zu bewegen. Zudem bestehen berechtigte Bedenken hinsichtlich der Auswirkungen von KI auf Privatsphäre und Datenschutz, insbesondere wenn diese für Gesichtserkennung oder Online-Tracking eingesetzt werden.

Die Auswirkungen von KI auf den Arbeitsmarkt sind noch unklar. Es besteht jedoch die Befürchtung, dass der großflächige Einsatz von KI in Unternehmen etliche Arbeitsplätze kosten könnte, obwohl ohen Zweifel auch neue Stellen geschaffen werden. Dennoch erwarten die Experten, dass KI die digitale Kluft (digital gap) weiter vergrößert. Sie warnen zudem vor der Gefahr, dass KI für Cyberangriffe genutzt werden könnte, was erhebliche Sicherheitsrisiken birgt.

Ein weiteres Risiko besteht in der Abhängigkeit von KI-Systemen und dem Verlust menschlicher Fähigkeiten. Die zunehmende Automatisierung von Aufgaben könnte dazu führen, dass Menschen bestimmte Fähigkeiten verlieren oder nicht mehr erlernen.

9. Die KI-Strategie der Deutschen Bundesregierung (2020)

Die Bundesregierung verfolgt seit 2018 eine Strategie, um Künstliche Intelligenz (KI) zu fördern und den Einsatz in verschiedenen Sektoren zu unterstützen. Die Bedeutung der Künstlichen Intelligenz für die Zukunft der Wirtschaft und Gesellschaft ist eklatant wichtig. Daher ist es unabdingbar, dass Deutschland und die Europäische Union eine führende Rolle in ihrer Entwicklung und Anwendung einnehmen. Allerdings besteht diesbezüglich noch Aufholbedarf gegenüber den Konkurrenten USA und China.

Die KI-Strategie der Bundesregierung konzentriert sich auf drei Schlüsselbereiche:

- Förderung der Forschung und Entwicklung: Die Bundesregierung will Forschung und Entwicklung im Bereich der KI stärken und unterstützen, um die wissenschaftliche Expertise in Deutschland zu verbessern. Dazu gehört die Schaffung von neuen Forschungsinstituten, die Bereitstellung von Mitteln für Forschungsprojekte und die Förderung der Zusammenarbeit zwischen Wissenschaft und Wirtschaft.

- Anwendung der KI in der Wirtschaft: Die KI-Strategie der Bundesregierung zielt darauf ab, die Implementierung und Nutzung der KI-Anwendungen in der deutschen Wirtschaft zu fördern.

- Auswirkungen auf die Gesellschaft und Ethik regulieren: Die KI-Strategie betont auch die Notwendigkeit, die gesellschaftlichen Auswirkungen der KI zu überwachen und zu regulieren. Es geht vor allem um die Sicherstellung, dass Künstliche Intelligenz und ihre spezifischen Anwendungen ethischen Normen entsprechen und Grundrechte respektiert werden. Ein bedeutender Aspekt ist auch die Ausbildung und Umschulung von Arbeitnehmern, um sie auf die Veränderungen am Arbeitsplatz vorzubereiten.

Die KI-Strategie der Bundesregierung Deutschlands verfolgt in diesem Sinne einen umfassenden Ansatz, um maßgeblichen Einfluss auf die Entwicklung, Anwendung und Regulierung der Künstlichen Intelligenz zu behalten. Es geht um die Erhaltung der Wettbewerbsfähigkeit Deutschlands, auch im Rahmen der Digitalen Transformation.

10. Die Zukunft der Künstlichen Intelligenz bis 2030

Die Zukunft der künstlichen Intelligenz (KI) ist ein Geflecht aus faszinierenden Möglichkeiten und zugleich ernsten Bedenken, eine Mischung aus verlockenden Potenzialen, anspruchsvollen Herausforderungen, bedrohlichen Risiken und zerstörerischen Gefahren. Diese Dualität von Chancen und Risiken prägt das Bild der KI-Zukunft. Es obliegt uns, diese Technologie verantwortungsbewusst zu handhaben und zu regulieren, um ein Gleichgewicht zwischen dem Nutzen und dem Schutz der Menschheit herzustellen.

Die Ausbreitung von KI-Systemen und Anwendungen wird zweifellos tiefgreifende Veränderungen in unserem gesellschaftlichen und wirtschaftlichen Miteinander hervorrufen. Ob diese Veränderungen eine Verbesserung oder Verschlechterung unseres Lebens mit sich bringen, bleibt abzuwarten. Ich wage jedoch die Prognose, dass sich die digitale Kluft zu einem tiefen Canyon ausweiten wird.

KI beinhaltet das Versprechen, eine Vielzahl drängender Herausforderungen unserer Zeit zu adressieren und möglicherweise sogar zu lösen. Dies reicht von der Optimierung der medizinischen Diagnose und Behandlungsmethoden bis hin zu Lösungsansätzen gegen den Klimawandel und Effizienzsteigerungen in Landwirtschaft und Verkehr.

Doch die mit KI-Sytemen verbundenen Gefahren kann man nicht übersehen. Bei Themen wie Arbeitsplatzverlust durch Automatisierung oder Schutz der Privatsphäre in unserer zunehmend vernetzten Welt sehe ich nicht nur unbeantwortete Fragen, sondern auch wachsende Bedenken. Die verlockende Aussicht auf eine lückenlose Überwachung bis in die intimsten Bereiche des Privatlebens lässt das Herz vieler Bürokraten in den Sicherheitsbehörden schon höher schlagen.

Die Anwendung von Künstlicher Intelligenz (KI) in autonomen Waffensystemen ist bereits Realität und wirft ebenfalls ernsthafte ethische und sicherheitsrelevante Fragen auf. Diese Technologien haben das Potential, Kriegsführung grundlegend zu verändern, da sie Ziele ohne menschliches Eingreifen auswählen und bekämpfen. Zudem sind diese autonomen Waffensysteme in der Lage, schneller und präziser zu agieren, wodurch sich die Risiken einer Eskalation signifikant erhöhen. Wie wir aktuell in der Ukraine sehen, sind viele international anerkannte Regeln zum Schutz der Bevölkerung im Krieg nicht viel mehr als bedrucktes Papier.

11. Fazit und Ausblick

Die Probleme sind komplex und es ist unwahrscheinlich, dass die Entwicklung dieser Technologie aufzuhalten ist. Daher ist es notwendig, effektive Kontrollmechanismen und Regelungen zu schaffen, um potenzielle Missbräuche und Risiken zu minimieren. Die wichtigsten Wirtschaftsnationen der Welt müssten den Dialog auf internationaler Ebene zu diesem Thema dringend fortsetzen und intensivieren. Allerdings ist eine solche Entwicklung momentan nicht erkennbar, ganz im Gegenteil. Anzeichen für ein technologisches Wettrüsten zwischen den USA und China sind unübersehbar.

Bild von Gerd Altmann auf Pixabay